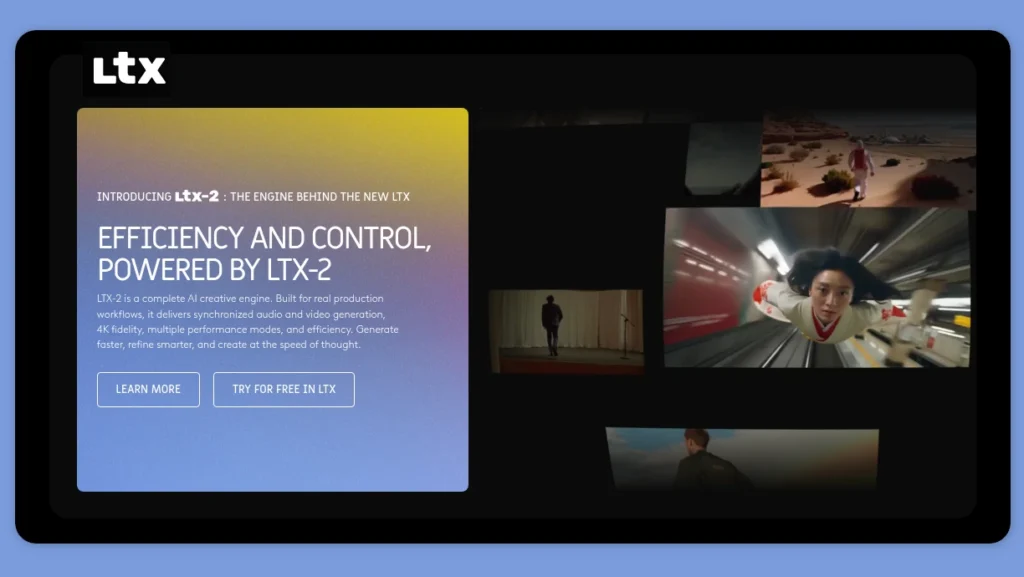

LTX-2: Lightricks nya AI-videomodell med synkat ljud

Lightricks företaget bakom Facetune och LTX Studio har lanserat något riktigt bra – LTX-2 är en AI-modell som för första gången kombinerar professionell video och ljud i ett enda system. Det här är inte bara en uppgradering, utan ett helt nytt sätt att jobba med AI-genererad video där du slipper mixa ihop ljud och bild i efterhand.

Modellen bygger på något som kallas DiT (Denoising Diffusion Transformer) och kan ta emot textual content, bilder, djupkartor och referensvideor som enter. Det coola är att den genererar allt från visuella effekter, rörelser, dialog, ambient ljud och musik i en enda course of.

Testa LTX-2 på Lightricks playground

Du kan testa LTX-2 through LTX studio : https://app.ltx.studio/ltx-2-playground/t2v

Det här är där LTX-2 verkligen skiljer sig från mängden. Den kan generera en 6-sekunders full HD-video på bara 5 sekunder – snabbare än videot spelas upp.

Öppen källkod – males inte än

Den fullständiga open source-releasen med modellvikter, träningskod och verktyg kommer att släppas på GitHub i slutet av november 2025.

LTX-2 lanserades strax efter Google släppte Veo 3.1 och samtidigt som OpenAI:s Sora 2 och ByteDance:s Seedance 1.0 drar till sig uppmärksamhet. Den stora skillnaden är att LTX-2 kommer att vara helt öppen källkod till skillnad från dessa proprietära alternativ.